Kompanija Apple otkazuje lansiranje svoje kontroverzne funkcije skeniranja fotografija za ilegalne fotografije djece, sistema koji je trebao skenirati fotografije postavljene na iCloud i iMessage četove u potrazi za znakovima ilegalnog seksualnog sadržaja. Najavljen prošlog mjeseca, sistem je trebao koristiti bazu podataka treće strane materijala o seksualnom zlostavljanju djece (CSAM) da traži znakove ilegalnih fotografija postavljenih u oblak, ali odmah naišao na otpor od strane zagovornika privatnosti.

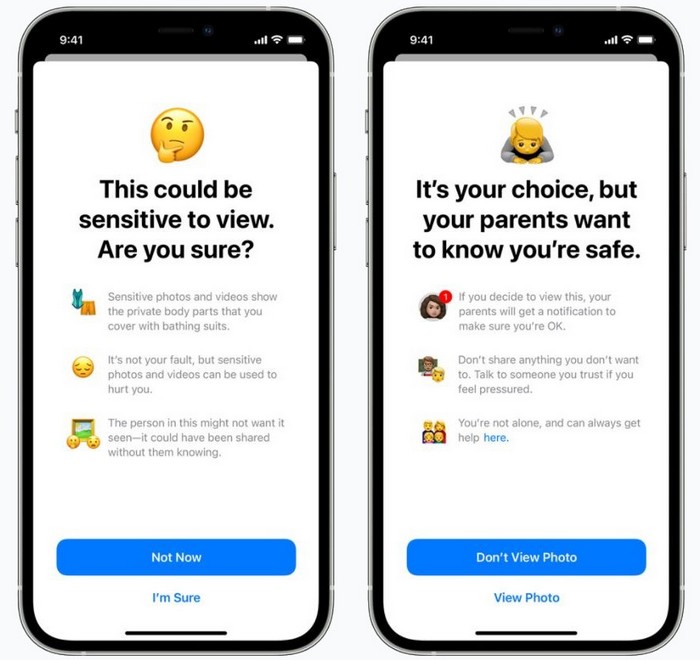

Zabunu je pogoršala činjenica da Apple zapravo je najavio dva sistema u isto vrijeme, iako je njihova funkcionalnost na mnogim mjestima bila pomiješana. Kao prvo, iMessage će koristiti prepoznavanje slika za označavanje potencijalno iskrenih fotografija koje se dijele u razgovorima s mlađim korisnicima. Ako takva slika postane javna, automatski se cenzurira i, kao opcija, roditelji se obavještavaju o njenom sadržaju.

U isto vrijeme, drugi sistem bi provjerio CSAM. Nadzirat će se samo slike postavljene na kompanijski iCloud Photos servis Apple, koristeći slike otisaka prstiju koje su kreirale stručne agencije na osnovu baze podataka sličnog nezakonitog sadržaja. Ako je otkriveno više takvih slika, Apple prijavio bi takvog korisnika nadležnima.

S obzirom na privatnost i sigurnost, Apple dao niz upozorenja. Skeniranje će se odvijati na uređaju, a ne daljinski, navela je kompanija, a otisci prstiju s kojima će se slike upoređivati neće sadržavati nikakav nezakonit sadržaj. Čak i ako su otpremljene slike označene, pregledat će ih čovjek prije sastavljanja izvještaja.

Međutim, protivnici ovih inovacija bili su odlučni. Sistem Apple je klizav teren, upozorili su, a kompanija iz Cupertina – uprkos njenim tvrdnjama o suprotnom – nesumnjivo će se suočiti sa pritiskom organa za sprovođenje zakona i vlada. Primjećeno je da bi mladi također mogli biti ugroženi i da bi njihovo pravo na privatnost bilo ugroženo Apple će ih slučajno prenijeti roditeljima kao LGBT putem iMessage sistema za skeniranje.

Prema nezvaničnim informacijama dobijenim od zaposlenih u kompaniji, menadžera Apple bili zapanjeni razmjerom reakcije i koliko je dugo trajalo. Sad Apple potvrdio je da ove godine više neće lansirati nove sisteme uz iOS 15, iPadOS 15, watchOS 8 i macOS Monterey.

"Prošlog mjeseca najavili smo planove za implementaciju funkcija osmišljenih da pomognu u zaštiti djece od predatora koji koriste komunikacijske alate za regrutaciju i eksploataciju, te da ograničimo distribuciju materijala o seksualnom zlostavljanju djece", navodi se u saopštenju. Apple. „Na osnovu povratnih informacija klijenata, grupa za zagovaranje, istraživača i drugih, odlučili smo da odvojimo dodatno vrijeme u narednim mjesecima da prikupimo informacije i napravimo poboljšanja prije nego što objavimo ove kritične funkcije za sigurnost djece.”

Da budemo jasni, ne govorimo o potpunom ukidanju novih CSAM sistema, već samo o odlaganju. Međutim, vjerovatno će to biti viđeno kao pobjedu od strane zagovornika privatnosti koji, iako su prepoznali potrebu da se djeca zaštite od predatorskog ponašanja, sumnjaju da je široko rasprostranjeno skeniranje najbolji način za to.

Pročitajte također:

- Apple će vam omogućiti korištenje drugih sistema plaćanja u App Store-u

- Apple bio je prvi u SAD koji je poskupio na 2,5 biliona dolara